Die robots.txt hilft Suchmaschinen, Ihre Seite zu lesen

Was ist eine robots.txt?

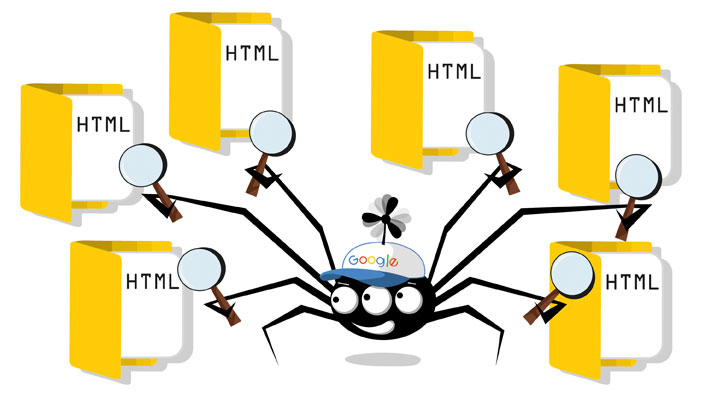

Suchmaschinen schicken regelmäßig sogenannte Crawler (auch Searchbots oder Spiders genannt) los, um Websites nach neuen Einträgen und Unterseiten abzusuchen. Mithilfe der robots.txt-Datei können Sie steuern, welche Unterseiten Ihrer Website nicht von den Crawlern erfasst und somit auch nicht in den Google-Index aufgenommen werden sollen. Die entsprechenden Seiten erscheinen dann also nicht in den Suchergebnissen. Dies können Sie natürlich nicht nur für Google festlegen, sondern auch für andere Suchmaschinen wie Bing, Yahoo und Co.

- Die Datei robots.txt bestimmt, was bei Suchmaschinen wie Google von der eigenen Site angezeigt werden soll.

- WordPress erstellt selbst eine virtuelle robots.txt, die automatisch ausgespielt wird.

- Für die meisten Webmaster sind eigene Ergänzungen sinnvoll.

Der Google-Crawler durchsucht Websites regelmäßig nach neuen Beiträgen zum Indexieren

Erstellt WordPress eine robots.txt-Datei automatisch?

WordPress erstellt eine eigene robots.txt-Datei, solange Sie selbst keine separate Datei anlegen. Die robots.txt von WordPress ist recht schmal gehalten und hat folgenden Inhalt:

- User-agent: *

- Disallow: /wp-admin/

- Disallow: /wp-includes/

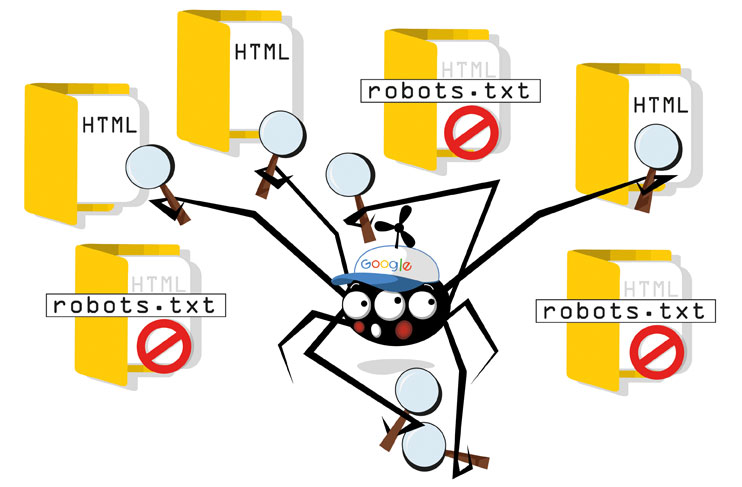

WordPress legt fest, welche Suchmaschine ihre Crawler (user-agent) bei Ihrer Site vorbeischickt (das Sternchen steht im Beispielfall für alle Suchmaschinen) und dass diese die komplette Website, bis auf die Verzeichnisse /wp-admin und /wp-includes/, indexieren dürfen. Durch den Befehl „disallow“ wird dem Bot der Zugriff auf die beiden genannten Verzeichnisse versperrt. Die genannten Standard-Einstellungen sind prinzipiell sinnvoll, denn mit ihnen stellen Sie sicher, dass der Crawler alle Seiten aufrufen kann. Dennoch ist es meist ratsam, für WordPress die robots.txt manuell anzupassen. Denn Unterseiten wie das Impressum müssen nicht bei Google gelistet werden. Auch die Plug-ins sollten nicht in den Suchergebnissen auftauchen. Denn falls ein Plug-in eine Sicherheitslücke aufweist, ist es für Angreifer ein Leichtes, die Websites zu finden, welche die Erweiterung aktiviert haben. Die robots.txt sollte also alles sperren, was nicht für die Öffentlichkeit bestimmt ist und dem Nutzer in der Google-Anzeige keinen Mehrwert bietet.

In der robots.txt wird festgelegt, was nicht gecrawlt werden sollte

Was sollte bei WordPress in die robots.txt-Datei hinein?

Jeder Webmaster definiert die robots.txt-Datei für WordPress anders, je nach der Seitenstruktur und den eigenen Präferenzen. Das folgende Beispiel gibt aber eine gute Orientierung, da es die wichtigsten Fälle abdeckt:

- User-agent: Googlebot-Image

- Disallow: Allow: /*

- User-agent: Mediapartners-Google

- Disallow: Allow: /*

- User-agent: duggmirror

- Disallow: /

- User-agent: *

- Disallow: /cgi-bin/

- Disallow: /wp-admin/

- Disallow: /wp-includes/

- Disallow: /wp-content/plugins/

- Disallow: /wp-content/cache/

- Disallow: /wp-content/themes/

- Disallow: /trackback/

- Disallow: /feed/

- Disallow: /comments/

- Disallow: /category/

- Disallow: /tag/

- Disallow: */trackback/

- Disallow: */feed/

- Disallow: */comments/

- Disallow: /*?

- Allow: /wp-content/uploads/

In den ersten Zeilen unter user-agent wird festgelegt, welchen Bots der Zugang erlaubt wird. Demnach sind die Google-Bildersuche sowie Google Ads erlaubt, duggmirror hingegen ist komplett gesperrt. Die Zeile user-agent: * drückt aus, dass die folgenden Einschränkungen für alle Suchmaschinen gelten. In den Zeilen darunter wird unter anderem definiert, dass das Admin-Verzeichnis (/wp-admin/) sowie Plug-ins (/wp-content/plugins/) und Themes (/wp-content/themes/) nicht gelistet werden. Auch die Kommentare, Archive und Feeds werden ausgeschlossen, um das Risiko für Duplicate Content zu verringern. Denn sind Beiträge sowohl auf Ihrer Site als auch in einem Extra-Archiv gelistet, kann Google Sie für den doppelten Content abstrafen, sodass sich beispielsweise Ihre Rankings verschlechtern. Das Sternchen in den letzten Befehlen sorgt dafür, dass sämtliche Dateien aus den Verzeichnissen „trackback“, „feed“ und „comments“ nicht gecrawlt werden. In der vorletzten Zeile legt das Sternchen fest, dass alle URLs, die ein Fragezeichen enthalten, nicht indexiert werden sollen. Um dem Google Crawler die Webseitenstruktur zu zeigen, kann man außerdem die Sitemap in die robots.txt-Datei eintragen.

Wie optimiere ich die robots.txt bei WordPress?

Die von WordPress erstellte robots.txt wird über die wp-functions.php-Datei erstellt und ausgegeben. Änderungen lassen sich mit einem Editor wie Notepad++ vornehmen. Allerdings werden diese Änderungen bei einem WordPress-Update überschrieben, sodass es zu einer Wiederherstellung der Standardeinstellungen kommt. Sinnvoller ist es, in einem Editor eine neue Datei mit dem Namen robots.txt zu erstellen und diese im Stammverzeichnis (auch Root-Verzeichnis genannt) Ihrer Domain abzuspeichern. Lautet Ihre Domain also http://www.ihre-beispielseite.de, muss der Pfad für die robots.txt wie folgt aussehen: http://www.ihre-beispielseite.de/robots.txt. Ist eine solche Datei erst einmal angelegt, erhält sie stets Vorrang vor der automatisch generierten robots.txt-Datei von WordPress.

robots.txt-Datei mit WordPress-Plug-ins erstellen

Bei WordPress gibt es für die Erstellung einer robots.txt noch einen einfacheren Weg, der über Plug-ins führt. Es gibt diverse SEO-Plug-ins, mit denen sich eine robots.txt direkt im Backend erstellen oder verändern lässt. Zu den bewährtesten Plug-ins zählt Yoast SEO. Haben Sie die Erweiterung erfolgreich installiert und aktiviert, gelangen Sie über die Menüpunkte „SEO => Werkzeuge“ und anschließend mit einem Klick auf „Datei-Editor“ an die Stelle, an der Sie direkt in WordPress die robots.txt-Datei bearbeiten können. Mit einem Klick auf „Änderungen in der robots.txt übernehmen“ werden Ihre Modifikationen gespeichert und sofort aktiv.

Mit einem Klick auf „Datei-Editor“ können Sie die robots.txt in WordPress ändern

Vorsicht: Nicht alle Bots halten sich an die robots.txt

Die Verhaltensvorschrift, die in der robots.txt-Datei für WordPress festgelegt wurde, dient den Suchmaschinen-Crawlern lediglich als Richtlinie, sie ist nicht bindend. Zwar halten sich die Bots von Google und anderen seriösen Suchmaschinen stets an deren Angaben, doch andere Crawler tun dies keineswegs immer. Wenn Sie also sichergehen möchten, dass bestimmte Teile Ihrer Website nirgendwo indexiert werden, sollten Sie über andere Blockierungsmethoden nachdenken – zum Beispiel über passwortgeschützte Dateien und Ordner auf Ihrem Server.

Fazit: Optimieren Sie die robots.txt für Ihr WordPress ggf. manuell

Mit einer robots.txt-Datei können Sie genau festlegen, welche Bereiche Ihrer Website von den Crawlern der Suchmaschinen aufgesucht werden dürfen und welche gesperrt bleiben. Mittels individueller Anpassungen können Sie das Verhalten der Suchmaschinen den Gegebenheiten Ihrer Website anpassen.

- Definieren Sie, welche Unterseiten für Google und andere Suchmaschinen gelistet werden sollen.

- Die robots.txt-Datei muss stets im Root-Verzeichnis Ihrer Domain gespeichert werden.

- WordPress-SEO-Plug-ins erleichtern die Erstellung und Bearbeitung einer robots.txt.